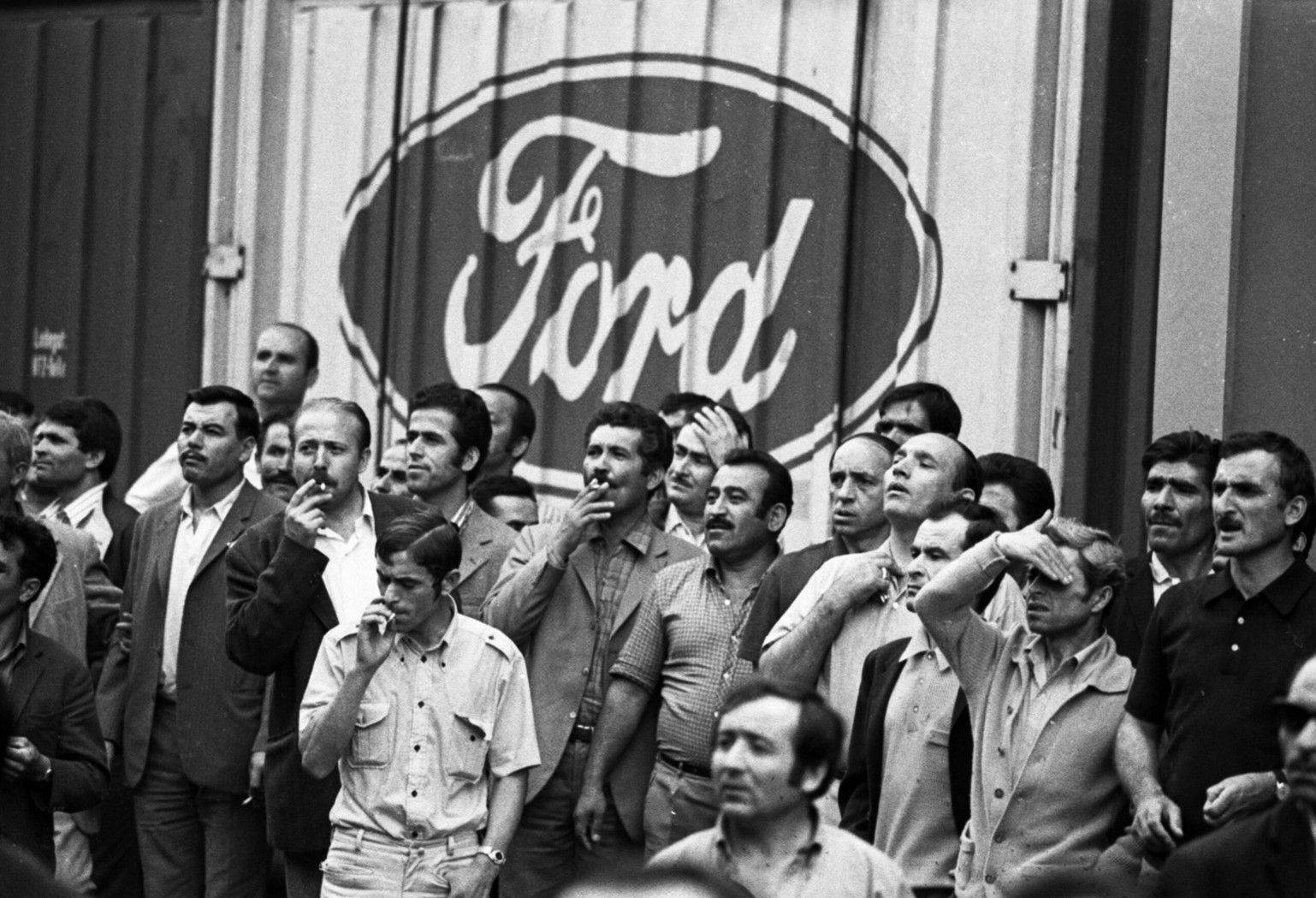

Grève spontanée à l’usine Ford à Cologne du 27 au 29 août 1973. © Klaus Rose/SIPA

CONTREPENSEES SUR L'IA

Avant toute chose, il faudrait remonter à l'époque de la Révolution industrielle et de l'automatisation : En disant que nous vivons dans de bien meilleures conditions qu’il y a 300 ans, il n’y a en effet pas besoin de remonter à l’époque des moulins à vent — mais plutôt au début de la révolution industrielle britannique, aux alentours de 1750, lorsque des technologies beaucoup plus avancées commencèrent à être utilisées dans les usines.

Une manière simpliste de résumer la révolution industrielle britannique consisterait à dire que tout le monde en a profité — y compris les travailleurs — et qu’il n’y aurait, partant, rien à craindre de la technologie. Mais un examen plus précis de cette histoire dessine un tableau plus complexe. Tout d’abord, pendant la majeure partie de cette période — soit environ cent ans — les travailleurs n’étaient pas très bien lotis...

Pourquoi remplacer les humains ?

Pour le comprendre il faut remonter à la pensée d’Alan Turing, le pionnier de l’informatique contemporaine. Turing, qui était un mathématicien, a essayé de conceptualiser ce que les machines devraient faire, ce qu’elles peuvent faire, et comment leurs actes peuvent être comparés à ceux de l’esprit humain. Il est arrivé à la conclusion que les ordinateurs fonctionnaient ou auraient dû fonctionner comme l’esprit humain — ou peut-être même que l’esprit humain fonctionnait déjà comme les ordinateurs qu’il avait imaginés. Si l’on suit cette vision, il devient souhaitable que les ordinateurs, les outils numériques, dans leur développement, prennent en charge de plus en plus de tâches accomplies par les humains.

Turing pensait que le cerveau humain n’était au fond rien d’autre qu’une machine de Turing. Cette idée avait une conséquence : en fin de compte, si vous avez une machine de Turing universelle, c’est qu’elle peut accomplir toutes les tâches cognitives que le cerveau humain accomplit. Il paraît évident que c’est ce point de vue que la communauté qui travaille à l’IA a épousé sans broncher.

Le vénérable petit groupe de gentlemen qui a donné naissance au domaine de l’IA lors de la conférence de Dartmouth en 1956 embrassait cette perspective : pour eux, l’IA était la branche censée développer l’intelligence autonome des machines. Leur objectif était de développer des machines capables d’accomplir des tâches comme les humains, de manière autonome, c’est-à-dire sans intervention extérieure.

Cette idée puissante a deux conséquences. D’un côté, si les machines sont déjà capables de faire des choses comme les humains et qu’elles s’améliorent progressivement, alors il faut leur confier plus de tâches, en les retirant aux humains. De l’autre, cette tendance ne créera pas non plus un moteur naturel pour inciter les humains à accomplir de nouvelles tâches et à étendre les capacités et les actions humaines.

Le problème est que cette perspective, du moins avant l’ère de l’IA, n’a pas été couronnée de succès. L’ère de l’innovation est toujours à nos portes, sous l’impulsion des outils numériques, mais les gains de productivité ne sont jamais au rendez-vous. Si l’on considère la mesure de la productivité préférée des économistes — la croissance de la productivité globale des facteurs — l’ère numérique est beaucoup plus lente en termes de croissance de la productivité que les décennies précédentes. Ce phénomène ne se limite pas aux États-Unis mais se retrouve aussi dans d’autres pays industrialisés.

Nous choisissons chaque jour le type d’institutions dans lesquelles nous vivons.

Daron Acemoğlu

La surutilisation de l’automatisation est problématique en raison de ses effets distributifs : si on en abuse — en remplaçant des tâches accomplies par des humains par celles que peuvent accomplir les machines — on n’obtient pas de bénéfices en termes de productivité, produisant un type d’automatisation paresseuse qu’on pourrait appeler une « so-so automation » : bien sûr, à la fin, les entreprises gagneront quelques dollars de plus parce qu’elles économisent sur les coûts de main-d’œuvre, mais il n’y aura pas de révolution de la productivité sans amélioration de la qualité des produits — un peu comme un service client automatisé, ou des caisses automatiques qui ne fonctionnent pas.

L’IA va-t-elle changer cela ? Je ne le pense pas. C’est pour cela que parler des technologies numériques et de l’IA comme d’un simple phénomène économique ne suffit pas. Ce sont des outils d’information, ce qui signifie qu’ils influencent tous les aspects de notre vie sociale, y compris la participation démocratique et politique.

La surveillance n’est qu’un aspect de la manière dont l’IA et d’autres outils connexes, en particulier les outils de reconnaissance faciale, vont affecter le paysage politique. Le contexte est beaucoup plus large que cela, car il s’agit du contrôle de quelque chose de fondamental : l’information. Tout le monde, du moins en Occident, reconnaît la nature problématique du système de crédit social qui a déjà été mis en œuvre en Chine, où il faut aller vérifier ses points avant de pouvoir passer à la caisse et acheter un billet pour assister à un spectacle ou prendre un métro.

Mais ce que nous avons ici n’est pas franchement beaucoup mieux.

Au lieu de donner au Parti communiste le monopole sur le contrôle de l’information, nous laissons à des entreprises privées le soin de la collecter, traiter et contrôler. Si l’on suit le raisonnement — à savoir qu’il n’y a pas de chevauchement nécessaire, pas d’alignement complet entre les intérêts des entreprises et ceux des travailleurs et de la société dans son ensemble — pourquoi devraient-ils avoir recours à ce contrôle massif, profond de l’information ? C’est une question qui nécessite une discussion beaucoup plus large.

Comment bifurquer ?

On peut conclure toutefois avec quelque chose de légèrement plus encourageant. Après avoir souligné les problèmes liés aux changements de direction de l’innovation, nous ne voudrions pas donner l’impression qu’il s’agit d’un piège dont on ne pourrait s’échapper. Nous avons toujours la possibilité de faire des choix qui sont essentiels. Nous choisissons chaque jour le type d’institutions dans lesquelles nous vivons. Nous choisissons la direction de l’innovation — ou, du moins, nous avons notre mot à dire, en théorie, sur cette direction. Le problème actuel est que nous renonçons à ce choix et laissons le débat sur le futur de l’IA à quelques individus. La société, les travailleurs, les syndicats doivent participer au débat sur l’IA. Il s’agit là d’une question cruciale. Le capitalisme social n’est pas né tout seul. Il a été construit par les syndicats et les organisations intermédiaires de la société civile. Il est impossible de construire une prospérité partagée si tous les outils du numérique poussent à l’automatisation et à la centralisation de l’information entre les mains de quelques grandes entreprises.

Il y a un choix à faire. Il est très intéressant de constater qu’à chaque étape de la révolution numérique, des personnes, pas les moindres, pensaient qu’il était possible et probable que les outils numériques jouent un rôle décentralisateur et démocratisant.

Au début de l’ère de la diffusion massive de l’ordinateur personnel, un activiste politique et un technologue, Ted Nelson, considérait que les grandes entreprises étaient en train de tuer la technologie parce qu’elles l’exploitaient de la mauvaise manière. Il considérait qu’une autre voie était possible. Ted Nelson n’a jamais réalisé de percée technologique, mais plusieurs autres personnes l’ont fait et constituent, à mon avis, un bien meilleur modèle pour les types d’IA que nous voulons.

À l’époque où Alan Turing développait sa vision des ordinateurs et de leur avenir, un mathématicien et ingénieur de renom, Norbert Wiener, produisait une œuvre remarquable. Dès 1949, il s’inquiétait de l’automatisation du travail par les robots et des effets pour les travailleurs et pour les salaires. Dans son travail, Norbert Wiener a exposé une vision différente de ce que la technologie devrait faire. Nous pouvons la désigner par la notion de « l’utilité de la machine » (machine usefulness), pour l’opposer à l’intelligence de la machine. Les machines doivent être au service de l’homme et de l’action humaine. Norbert Wiener, qui était lui-même un ingénieur théoricien, n’a jamais proposé de technologies pour y parvenir, mais plusieurs autres personnes l’ont fait. Douglas Engelbart et ses étudiants, dans les années 1950 et 1960, ont réalisé de nombreuses avancées telles que l’invention de la souris, les ordinateurs à menu, les hyperliens, l’hypertexte… que nous considérons aujourd’hui comme allant de soi, parce qu’ils structurent notre monde. Ces outils ne sont pas le fruit d’une vision selon laquelle nous devrions tout automatiser à tout prix. Bien au contraire, ils montrent la possibilité d’une complémentarité homme-machine.

Les machines doivent être au service de l’homme et de l’action humaine.

Daron Acemoğlu

Joseph Carl Robnett Licklider, qui pourrait être considéré comme le père de l’internet parce qu’il en a conçu et soutenu le développement au sein de l’ARPA, avait exactement la même idée. Il en parlait avec une expression qu’il faut récupérer : la symbiose homme-machine (man machine symbiosis). Ce sont ces penseurs qui ont pensé une bifurcation. C’est en les suivant que nous pouvons développer les outils d’une manière qui permettrait aux humains d’en faire plus, pas moins.

L’IA, si elle était conçue sans se limiter à l’automatisation, pourrait aller dans ce sens. En tant qu’outil d’information, elle pourrait donner plus de capacités à de nombreuses personnes plutôt que de chercher à les remplacer.

Toutefois, ce n’est pas la direction que nous prenons. Comment faire pour dire quelque chose qui ne ressemble pas à un simple vœu pieux ? Je conçois que l’on puisse penser que tout se passe comme si je postulais que tous ces immenses génies de la Silicon Valley ne savaient pas ce qui est le mieux pour nous tous, pour la société et pour nos institutions et que nous, analystes qui restons à l’extérieur du développement, ne pouvons pas avoir une vision différente de ce qui est peut-être plus souhaitable… La réglementation gouvernementale et la pression sociétale pourraient changer la donne. De nombreux économistes diraient qu’il s’agit là d’un raisonnement fantaisiste, mais ce n’est pas aussi fantaisiste que l’on pourrait le croire.

Un exemple l’illustre très bien : le secteur de l’énergie. Pendant des décennies, nous avons construit, encore et encore, plus de technologies basées sur les combustibles fossiles. Les ingénieurs qui les ont mises en place n’ont pas tenu compte du fait que si les technologies liées aux combustibles fossiles étaient très rentables pour eux, elles n’étaient pas bonnes pour la société. Il a fallu des négociations, des réglementations, l’action de plusieurs gouvernements, des subventions pour l’innovation verte et la pression de la société pour changer la donne. À la fin des années 1990 et au début des années 2000, les énergies renouvelables étaient 20 fois plus chères pour produire de l’électricité. Mais nous avons bénéficié d’énormes progrès technologiques et d’un apprentissage par la pratique.

Aujourd’hui, elles sont moins chères que les combustibles fossiles pour produire de l’électricité.

Notre route n’est pas tracée. Nous pouvons encore bifurquer.

Proposé par la rédaction du Tablier-info

Production de la Golf à l’usine Volkswagen le 10 mai 1979 à Wolfsburg, Allemagne, Europe. © Klaus Rose/SIPA